【新智元導讀】Grok-2正式開源,登上Hugging Face,9050億參數+128k上下文有多猛?近萬億參數「巨獸」功能首曝。馬斯克再現「超人」速度,AI帝國正在興起。

什么?馬斯克總算開源了Grok-2!

一大早,xAI正式官宣,向一切人開源Grok-2!

馬斯克還預告,Grok-3將在6個月后開源。

Grok-2于2024年完結練習,體積超500GB。其混合專家(MoE)架構在Grok-1的根底上進行了改善。

那Grok-2究竟開源了哪些部分?開源版別的技能特色是什么?開源權限有什么?

咱們為你逐個梳理了下,上干貨:

開源了什么?

xAI本次向一切用戶開源了Grok-2以下中心部分:

模型權重

模型架構

Grok-2開源版別技能特色

這個開源的「大腦」具有十分強壯的技能標準:

巨大的模型規劃:總參數量高達9050億(905B),在推理時,每次會激活其間的1360億(136B)參數。這使它成為現在最強壯的開源模型之一。

超長的上下文窗口:支撐高達131,072 (128k) token的上下文長度。

這意味著它能夠一次性閱覽和處理十分長的文檔或對話前史(大約相當于一本200多頁的書),進行更雜亂的推理和總結。

混合專家架構 (MoE):這種架構能夠在不添加巨大計算成本的前提下,大幅擴展模型規劃,提高模型才能。

較新的練習數據:其預練習數據覆蓋了很多的文本和代碼,截止到2024年頭。

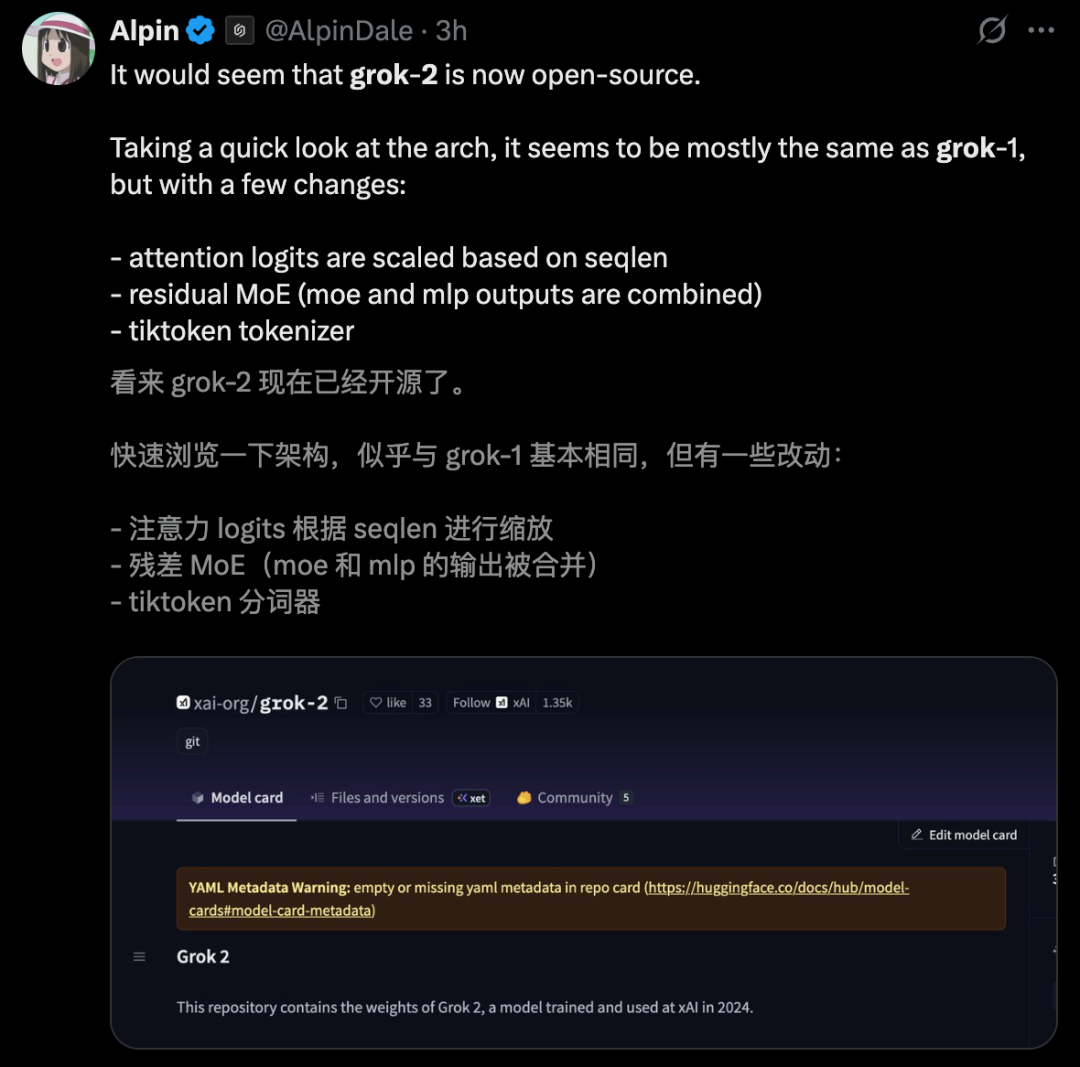

Grok-2和Grok-1架構不同點,網友對此做了一個總結:

開源權限是什么?

商業用途門檻:僅當相關公司年收入低于一百萬美元時,才可用于商業用途。超越此門檻的亞洲直播av男一女三在線觀看商業用途需取得xAI的獨自答應。

約束:除非本協議條款答應對Grok 2進行修正或微調,不然不得運用資料、衍生品或輸出(包括生成的數據)來練習、創立或改善任何根底、大型言語或通用人工智能模型。

現在,Grok-2現已正式開源,可在Hugging Face上下載。

運用方法:通過SGLang布置

下載權重文件

你能夠把/local/grok-2替換成恣意你喜愛的文件夾稱號。

hf download xai-org/grok-2 --local-dir /local/grok-2

下載過程中你可能會遇到一些過錯,請屢次重試直到下載成功。

假如下載成功,該文件夾下應包括42個文件,總巨細大約為500GB。

發動服務器

裝置最新版的SGLang推理引擎(版別≥v0.5.1),地址:

https://github.com/sgl-project/sglang/

運用以下指令發動推理服務器。這個檢查點(checkpoint)裝備為 TP=8,所以需求8張GPU(每張顯存大于40GB)。

python3 -m sglang.launch_server --model /local/grok-2 --tokenizer-path /local/grok-2/tokenizer.tok.json --tp 8 --quantization fp8 --attention-backend triton

發送懇求

這是一個通過額定練習的模型,所以需求運用正確的對話模板。

python3 -m sglang.test.send_one --prompt "Human: What is your name?<|separator|>Assistant:"

你應該能看到模型輸出姓名——Grok。

大佬點評

網友XFreeze稱,xAI開展的速度極端驚人!

他泄漏,xAI坐落孟菲斯的巨像數據中心僅用122天建成并全面投入運營,裝備100,000塊英偉達H100 GPU。

「短短兩年內,xAI憑仗Grok 4的發布,以極端精簡的團隊登頂全球最強人工智能之巔。」他感亞洲直播av男一女三在線觀看嘆道。

黃仁勛曾稱,這是「超人」之舉,只要馬斯克能做到!

在人工智能開展進程上,有網友毫不小氣地贊許馬斯克和xAI:他們正以光速推進AI的前進。

他還預告,Grok 5練習行將開端。

有網友感嘆道,92天內將容量翻倍,這不是本錢分配帶來的成果,而是一種繞過傳統運用一種新的運營戰略帶來的。

有網友表明,這一切,就像在實時觀看一個科幻夢想成真——真實達到了立異的巔峰!

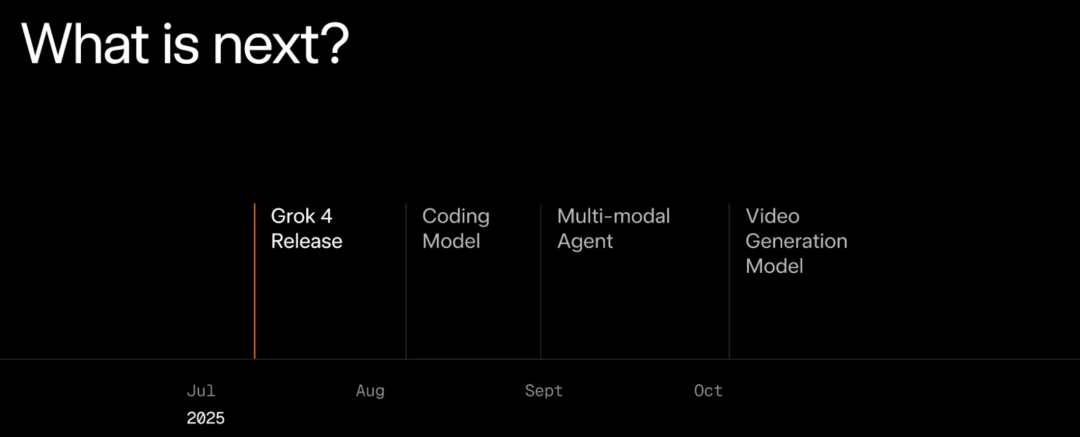

Grok 4發布會上,馬斯克曾預告了下一步路線圖——

8月將發布編碼模型,9月發布多模態智能體,10月發布視頻生成模型。

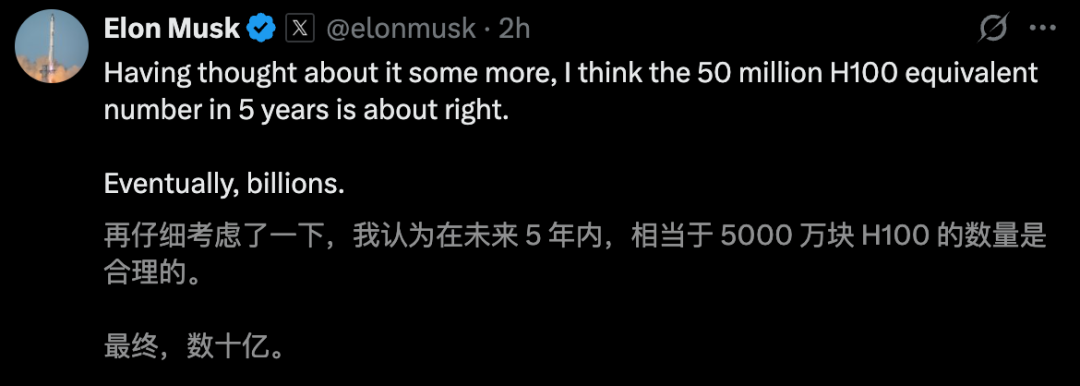

xAI模型能飛速迭代,首要背靠了強壯的超算中心。估計5年內,xAI將打造出5000塊H100巨無霸超算。

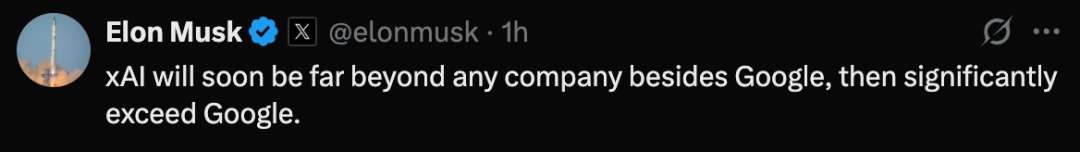

老馬自傲滿滿地表明,「xAI很快就能干掉谷歌以外的一切對手,就連谷歌,超越它也是早晚的事」。

真是有點等待,下一個AI帝國誕生了。